NVIDIA a présenté une vague de recherches de pointe en intelligence artificielle qui permettra aux développeurs et aux artistes de donner vie à leurs idées, qu’il s’agisse d’images fixes ou animées, en 2D ou 3D, hyperréalistes ou fantastiques.

Une vingtaine d’articles de NVIDIA Research faisant progresser l’IA générative et les graphiques neuronaux – y compris des collaborations avec plus d’une douzaine d’universités aux États-Unis, en Europe et en Israël – seront présentés au SIGGRAPH 2023, la première conférence sur l’infographie, qui se tiendra du 6 au 10 août à Los Angeles.

Les publications de recherche de NVIDIA RESEARCH sont accessibles ici.

Les articles incluent des modèles d’IA génératifs qui transforment le texte en images personnalisées ; des outils de rendu inverse qui transforment des images fixes en objets 3D ; des modèles de physique neuronale qui utilisent l’IA pour simuler des éléments 3D complexes avec un réalisme époustouflant ; et des modèles de rendu neuronal qui débloquent de nouvelles capacités pour générer des détails visuels en temps réel alimentés par l’IA. Voici quelques exemples.

Repenser le modèle texte vers image

Les modèles d’IA générative qui transforment le texte en images sont des outils puissants pour créer des concepts artistiques ou des storyboards pour des films, des jeux vidéo et des mondes virtuels 3D. Les outils d’intelligence artificielle texte vers image peuvent transformer une invite telle que « jouets pour enfants » en visuels presque infinis qu’un créateur peut utiliser comme source d’inspiration – générant des images d’animaux en peluche, de blocs ou de puzzles.

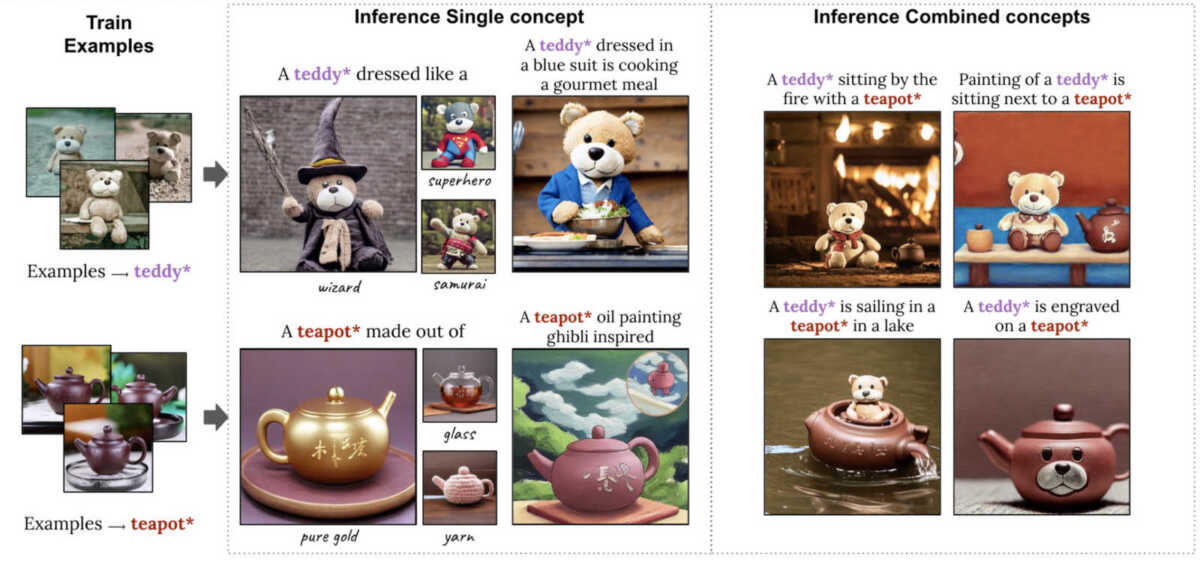

Cependant, les artistes peuvent avoir un sujet particulier en tête. Un directeur créatif pour une marque de jouets, par exemple, pourrait planifier une campagne publicitaire autour d’un nouvel ours en peluche et souhaiter visualiser le jouet dans différentes situations, comme un goûter avec un ours en peluche. Pour permettre ce niveau de spécificité, des chercheurs de l’Université de Tel Aviv et de NVIDIA ont deux articles SIGGRAPH qui permettent aux utilisateurs de fournir des exemples d’images dont le modèle apprend rapidement.

Un article décrit une technique qui nécessite un seul exemple d’image pour personnaliser sa sortie, accélérant le processus de personnalisation de quelques minutes à environ 11 secondes sur un seul GPU NVIDIA A100 Tensor Core, plus de 60 fois plus rapide que les approches de personnalisation précédentes.

Un deuxième article présente un modèle très compact appelé Perfusion, qui prend une poignée d’images conceptuelles pour permettre aux utilisateurs de combiner plusieurs éléments personnalisés – comme un ours en peluche et une théière spécifiques – en un seul visuel généré par l’IA :

Donner vie à la 2D

Une fois qu’un créateur propose un « concept art » pour un monde virtuel, l’étape suivante consiste à en faire un rendu et à le remplir d’objets et de personnages 3D. NVIDIA Research invente des techniques d’intelligence artificielle pour accélérer ce processus chronophage en transformant automatiquement les images et les vidéos 2D en représentations 3D que les créateurs peuvent importer dans des applications graphiques pour une édition ultérieure.

Un troisième article créé avec des chercheurs de l’Université de Californie à San Diego dévoile une technologie capable de générer et de rendre un modèle 3D photoréaliste de la tête et des épaules basé sur un seul portrait 2D – une percée majeure qui rend la création d’avatars 3D et la visioconférence 3D accessible avec l’IA. La méthode s’exécute en temps réel sur un ordinateur de bureau grand public et peut générer une téléprésence 3D photoréaliste ou stylisée en utilisant uniquement des webcams conventionnelles ou des caméras de smartphone.

Un quatrième projet, issue d’une collaboration avec l’Université de Stanford, apporte un mouvement réaliste aux personnages 3D. Les chercheurs ont créé un système d’intelligence artificielle capable d’apprendre une gamme de techniques de tennis à partir d’enregistrements vidéo 2D de vrais matchs de tennis et d’appliquer ce mouvement à des personnages 3D. Les joueurs de tennis simulés peuvent frapper la balle avec précision pour cibler des positions sur un terrain virtuel et même jouer des échanges prolongés avec d’autres personnages.

Au-delà du test du tennis, cet article SIGGRAPH aborde le défi difficile de produire des personnages 3D capables d’exécuter diverses compétences avec des mouvements réalistes – sans l’utilisation de données de capture de mouvement coûteuses.

La difficile physique des cheveux, simplifiée par l’IA

Une fois qu’un personnage 3D est généré, les artistes peuvent superposer des détails réalistes tels que les cheveux – un défi complexe et coûteux en calcul pour les animateurs.

Les humains ont en moyenne 100.000 cheveux sur la tête (je fais manifestement baisser cette moyenne), chacun réagissant dynamiquement au mouvement d’un individu et à l’environnement qui l’entoure. Traditionnellement, les créateurs utilisent des formules physiques ou des plugins dédiés pour calculer le mouvement des cheveux, simplifiant les mouvements en fonction des ressources disponibles. C’est pourquoi les personnages virtuels d’un film à gros budget arborent des cheveux beaucoup plus détaillés que les avatars de jeux vidéo en temps réel.

Un cinquième article présente une méthode capable de simuler des dizaines de milliers de cheveux en haute résolution et en temps réel à l’aide de la physique neuronale, une technique d’IA qui enseigne à un réseau neuronal à prédire comment un objet se déplacerait dans le monde réel.

Le rendu neuronal pour une qualité cinématographique en temps réel

Une fois qu’un environnement est rempli d’objets et de personnages 3D animés, le rendu en temps réel simule la physique de la lumière réfléchie à travers la scène virtuelle. Des recherches récentes de NVIDIA montrent comment les modèles d’IA pour les textures, les matériaux et les volumes peuvent fournir des visuels photoréalistes de qualité cinématographique en temps réel pour les jeux vidéo.

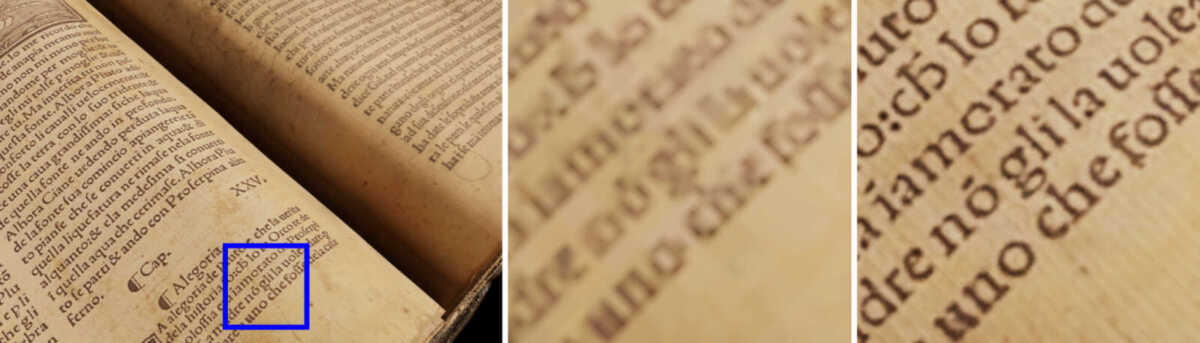

Dans un sixième article SIGGRAPH, NVIDIA présentera la compression de texture neurale qui offre jusqu’à 16 fois plus de détails de texture sans utiliser de mémoire GPU supplémentaire. La compression de texture neuronale peut augmenter considérablement le réalisme des scènes 3D, comme le montre l’image ci-dessous, qui montre comment les textures compressées neuronales (à droite) capturent des détails plus nets que les formats précédents, où le texte reste flou (au centre).

Ce que vous venez de lire ne sont que quelques exemples qui seront présentés au SIGGRAPH. L’ensemble des publications de recherche de NVIDIA est accessible à cette adresse : https://research.nvidia.com/publications

On y retrouve des études sur la simulation des fluides, la physique des tissus, ou des effets de surface. Le SIGGRAPH 2023 sera assurément sous le signe de l’IA.